Multi-Layer-Perzeptron

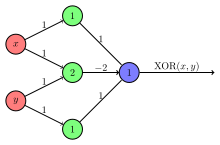

Ein Multi-Layer Perceptron (MLP, deutsch Mehrlagiges Perzeptron) ist ein künstliches neuronales Netzwerk (KNN), das in der maschinellen Lernforschung und im Bereich des überwachten Lernens weit verbreitet ist. Es besteht aus mindestens drei Schichten von Neuronen: einer Eingabeschicht, einer oder mehreren verdeckten Schichten und einer Ausgabeschicht. Das MLP kann als ein gerichteter azyklischer Graph betrachtet werden, bei dem die Neuronen in einer Schicht mit den Neuronen in den nachfolgenden Schichten vollständig verbunden sind.

Architektur

[Bearbeiten | Quelltext bearbeiten]

Das MLP besteht aus einer Eingabeschicht, einer oder mehreren verdeckten Schichten und einer Ausgabeschicht. Jede Schicht enthält eine Gruppe von Neuronen, die miteinander verbunden sind. Die Neuronen in aufeinanderfolgenden Schichten sind vollständig miteinander verbunden, was bedeutet, dass jedes Neuron in einer Schicht mit jedem Neuron in der nächsten Schicht verbunden ist. Jede Verbindung zwischen Neuronen hat ein Gewicht, das während des Trainings angepasst wird.

Vorwärtspropagation

[Bearbeiten | Quelltext bearbeiten]Die Vorwärtspropagation (englisch Forward Propagation) ist der Prozess, bei dem die Eingabewerte durch das Netzwerk propagiert werden, um Vorhersagen zu generieren. Jedes Neuron in den verdeckten Schichten und der Ausgabeschicht berechnet eine gewichtete Summe der Eingangswerte, die durch die Verbindungen mit den vorherigen Schichten gewichtet sind. Anschließend wird diese gewichtete Summe durch eine Aktivierungsfunktion verarbeitet, um den Ausgangswert des Neurons zu bestimmen.

Gewichtete Summe

[Bearbeiten | Quelltext bearbeiten]Um die gewichtete Summe eines Neurons zu berechnen, werden die Eingangswerte mit den entsprechenden Gewichten multipliziert und anschließend aufsummiert. Jedes Neuron besitzt ein Gewicht für jede Verbindung zu den Neuronen in der vorherigen Schicht. Die gewichteten Summen werden für jedes Neuron in den verdeckten Schichten und der Ausgabeschicht berechnet.

Aktivierungsfunktion

[Bearbeiten | Quelltext bearbeiten]Nachdem die gewichtete Summe berechnet wurde, wird sie durch eine Aktivierungsfunktion verarbeitet, um den Ausgangswert des Neurons zu bestimmen. Die Aktivierungsfunktion kann nichtlineare Eigenschaften in die Ausgabe des Neurons einführen und ermöglicht es dem Multi-Layer Perceptron, komplexe Zusammenhänge zu erlernen.

Es gibt verschiedene Aktivierungsfunktionen, die im MLP verwendet werden können. Eine häufig verwendete Funktion ist die Sigmoidfunktion, auch als logistische Funktion bezeichnet.

Eine andere weit verbreitete Aktivierungsfunktion ist die Rectified Linear Unit (ReLU) Funktion.[1]

Die Wahl der Aktivierungsfunktion hängt von der spezifischen Aufgabe und den Anforderungen des Problems ab. Sigmoidale Funktionen haben den Vorteil, dass sie die Ausgabe auf einen Wertebereich zwischen 0 und 1 begrenzen, während ReLU-Funktionen die Berechnungen beschleunigen können, da sie keine exponentiellen Operationen beinhalten.

Ausgabeschicht

[Bearbeiten | Quelltext bearbeiten]Die Ausgabeschicht des MLP generiert die Vorhersagen des Netzwerks. Jedes Neuron in der Ausgabeschicht ist mit den Neuronen in der letzten verdeckten Schicht verbunden. Die Ausgangswerte der Neuronen in der Ausgabeschicht repräsentieren die Vorhersagen des MLP für die gegebene Eingabe.

Nach der Vorwärtspropagation werden die Vorhersagen mit den erwarteten Ausgaben verglichen, um den Fehler zu berechnen. Dieser Fehler wird anschließend während des Trainingsprozesses verwendet, um die Gewichte im MLP anzupassen und die Leistung des Netzwerks zu verbessern. Der Backpropagation-Algorithmus wird oft verwendet, um die Gewichtsaktualisierung zu berechnen.

Der Backpropagation-Algorithmus nutzt das Konzept der Kettenregel, um den Einfluss jedes Gewichts auf den Gesamtfehler des Netzwerks zu berechnen. Dieser Fehler wird rückwärts durch das Netzwerk propagiert, wobei die Gewichtsaktualisierung jedes Neurons in den verdeckten Schichten und der Ausgabeschicht basierend auf seinem Beitrag zum Gesamtfehler berechnet wird. Dieser Prozess wird iterativ durchgeführt, indem die Gewichte schrittweise angepasst werden, bis eine Konvergenz erreicht ist.

Die Vorwärtspropagation und der Backpropagation-Algorithmus werden während des Trainingsprozesses wiederholt ausgeführt, um das MLP auf die gegebenen Daten anzupassen. Durch das iterative Lernen passt das Netzwerk die Gewichte an, um die Leistung zu optimieren und die Vorhersagegenauigkeit zu verbessern.

Es ist wichtig zu beachten, dass die Beschreibung der Vorwärtspropagation und des Backpropagation-Algorithmus eine vereinfachte Darstellung ist und weitere Aspekte wie die Verwendung von Bias-Neuronen, Regularisierungstechniken und Optimierungsverfahren berücksichtigt werden können, um die Leistung des MLP weiter zu verbessern.

Trainingsprozess

[Bearbeiten | Quelltext bearbeiten]Der Trainingsprozess im Multi-Layer Perceptron umfasst die Anpassung der Gewichte, um die Leistung des Netzwerks zu optimieren. Während des Trainingsprozesses wird der Fehler zwischen den Vorhersagen des MLP und den erwarteten Ausgaben berechnet und verwendet, um die Gewichte im Netzwerk zu aktualisieren. Dies wird typischerweise mithilfe des Backpropagation-Algorithmus erreicht, der die Kettenregel des Differenzierens verwendet, um den Fehler rückwärts durch das Netzwerk zu propagieren.

Der Trainingsprozess kann in mehrere Schritte unterteilt werden:

- Initialisierung der Gewichte: Die Gewichte im MLP werden zufällig initialisiert, bevor der Trainingsprozess beginnt. Eine sorgfältige Initialisierung der Gewichte kann die Konvergenzgeschwindigkeit des Netzwerks beeinflussen.

- Vorwärtspropagation: Während des Trainingsprozesses wird die Vorwärtspropagation verwendet, um die Vorhersagen des MLP für eine gegebene Eingabe zu generieren. Die Eingabewerte werden durch das Netzwerk propagiert, wobei die gewichteten Summen und die Aktivierungsfunktionen in den Neuronen angewendet werden, um die Ausgangswerte zu berechnen.

- Fehlerberechnung: Nach der Vorwärtspropagation werden die Vorhersagen des MLP mit den erwarteten Ausgaben verglichen, um den Fehler zu berechnen. Es gibt verschiedene Fehlermaße, die verwendet werden können, abhängig von der Art der Aufgabe. Zum Beispiel wird für die Klassifikation oft der Kreuzentropie-Fehler oder der quadratische Fehler verwendet.

- Backpropagation: Der Backpropagation-Algorithmus wird verwendet, um den Fehler rückwärts durch das Netzwerk zu propagieren und die Gewichte zu aktualisieren. Der Fehler wird von der Ausgabeschicht zur Eingabeschicht rückwärts durch das Netzwerk propagiert. Dabei wird die Kettenregel des Differenzierens angewendet, um den Einfluss jedes Gewichts auf den Gesamtfehler zu berechnen. Die Gewichte werden entsprechend angepasst, um den Fehler zu minimieren.

- Gewichtsaktualisierung: Nachdem der Fehler rückwärts propagiert wurde, werden die Gewichte im Netzwerk aktualisiert. Die Gewichtsaktualisierung erfolgt in kleinen Schritten, die durch einen Lernrate-Hyperparameter gesteuert werden. Die Lernrate beeinflusst die Größe der Gewichtsaktualisierung und kann die Konvergenz des Netzwerks beeinflussen. Es ist wichtig, eine passende Lernrate zu wählen, um ein gutes Gleichgewicht zwischen Konvergenzgeschwindigkeit und Stabilität zu erreichen.

- Iteration: Der Trainingsprozess wird iterativ wiederholt, indem die Schritte der Vorwärtspropagation, Fehlerberechnung, Backpropagation und Gewichtsaktualisierung durchgeführt werden. Dies geschieht für jede Eingabe im Trainingsdatensatz. Das Netzwerk lernt allmählich, die Gewichte anzupassen, um den Fehler zu minimieren und die Vorhersagen zu verbessern.

- Epochen: Der Trainingsprozess erfolgt über mehrere Epochen. Eine Epoche bedeutet, dass alle Eingaben im Trainingsdatensatz einmal durch das Netzwerk propagiert wurden. Das Netzwerk wird normalerweise über mehrere Epochen trainiert, um die Leistung zu verbessern und sicherzustellen, dass es die Muster im Trainingsdatensatz erlernt hat.

- Überanpassung (englisch Overfitting): Beim Training eines MLP besteht das Risiko des Überanpassens an den Trainingsdatensatz. Überanpassung tritt auf, wenn das Netzwerk die Trainingsdaten zu gut lernt und Schwierigkeiten hat, auf neuen Daten zu generalisieren. Um Überanpassung zu vermeiden, werden Techniken wie Regularisierung, Drop-out und Kreuzvalidierung eingesetzt, um die allgemeine Leistung des Netzwerks zu verbessern.

- Validierung: Während des Trainingsprozesses wird regelmäßig eine Validierung auf einem separaten Validierungsdatensatz durchgeführt. Dies ermöglicht die Überwachung der Leistung des MLP auf Daten, die es nicht während des Trainings gesehen hat. Die Validierung wird verwendet, um den Fortschritt des Trainings zu beurteilen und Überanpassung zu erkennen.

- Konvergenz: Der Trainingsprozess wird fortgesetzt, bis eine Konvergenz erreicht ist. Konvergenz bedeutet, dass der Fehler des MLP auf dem Trainingsdatensatz nicht mehr wesentlich reduziert werden kann und dass das Netzwerk eine stabile Leistung erreicht hat. Die Anzahl der benötigten Epochen für die Konvergenz kann variieren und hängt von der Komplexität des Problems und dem Trainingsdatensatz ab.

- Test: Nach dem Training wird die Leistung des MLP auf einem separaten Testdatensatz bewertet, der unabhängig von den Trainings- und Validierungsdaten ist. Dies ermöglicht eine objektive Bewertung der Fähigkeit des Netzwerks, auf neuen Daten zu generalisieren.

Anwendungen

[Bearbeiten | Quelltext bearbeiten]Multi-Layer Perceptrons sind eine weit verbreitete Art von künstlichen neuronalen Netzwerken und finden Anwendung in einer Vielzahl von Bereichen. Durch ihre Fähigkeit, komplexe nichtlineare Beziehungen zu modellieren und aus großen Datenmengen zu lernen, haben MLPs in verschiedenen Bereichen beeindruckende Leistungen erbracht. Im Folgenden werden einige der prominentesten Anwendungen von MLPs erläutert:

Bild- und Spracherkennung

[Bearbeiten | Quelltext bearbeiten]MLPs haben sich als äußerst effektiv bei der Bild- und Spracherkennung erwiesen. In der Bilderkennung können MLPs verwendet werden, um Objekte, Gesichter oder Handgeschriebenes zu erkennen. Sie werden häufig in Anwendungen wie Gesichtserkennungssystemen, Fahrerassistenzsystemen und Bildgebungsverfahren eingesetzt. MLPs haben auch in der Spracherkennung große Fortschritte erzielt und werden in Sprachassistenten, automatischen Übersetzungssystemen und Transkriptionssoftware eingesetzt.

Natürliche Sprachverarbeitung

[Bearbeiten | Quelltext bearbeiten]Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP, siehe Computerlinguistik) ist ein Bereich, in dem MLPs häufig eingesetzt werden. MLPs werden verwendet, um Sprachmuster zu erlernen, semantische Beziehungen zu erkennen, Textklassifizierungsaufgaben durchzuführen und maschinelle Übersetzungen zu verbessern. Sie finden Anwendung in Chatbots, Textanalysetools, Empfehlungssystemen und automatischer Textgenerierung.

Finanzanalyse

[Bearbeiten | Quelltext bearbeiten]MLPs werden in der Finanzanalyse eingesetzt, um komplexe Muster in Finanzdaten zu erkennen und Vorhersagen zu treffen. Sie können zur Vorhersage von Börsenkursen, zur Betrugserkennung in Kreditkartenabrechnungen, zur Kreditwürdigkeitsprüfung und zur Risikomodellierung eingesetzt werden. MLPs ermöglichen es Finanzinstituten, präzise Prognosen zu erstellen, Risiken zu bewerten und fundierte Entscheidungen zu treffen.[2]

Medizinische Diagnose und Bildgebung

[Bearbeiten | Quelltext bearbeiten]In der medizinischen Anamnese und Bildgebung werden MLPs eingesetzt, um Krankheiten zu erkennen, medizinische Bilder zu analysieren und Patientendaten zu verarbeiten. Sie können zum Beispiel in der Diagnose von Krebs, der Erkennung von Anomalien in medizinischen Bildern wie MRI-Scans und CT-Scans, der Vorhersage von Krankheitsverläufen und der personalisierten Medizin eingesetzt werden. MLPs ermöglichen es Ärzten, genaue Diagnosen zu stellen und Behandlungsentscheidungen zu treffen.

Robotik und Steuerungssysteme

[Bearbeiten | Quelltext bearbeiten]MLPs werden in der Robotik eingesetzt, um autonome Roboter zu steuern, Bewegungsabläufe zu erlernen und Objekte zu erkennen. Sie finden auch Anwendung in Steuerungssystemen für komplexe Prozesse, bei denen MLPs eingesetzt werden, um komplexe Regelungen zu erlernen und optimale Entscheidungen zu treffen. Beispielsweise können MLPs in der industriellen Automatisierung verwendet werden, um Produktionsabläufe zu optimieren, Fehler zu erkennen und autonomes Verhalten von Robotern zu ermöglichen.

Verkehrsvorhersage und Verkehrssteuerung

[Bearbeiten | Quelltext bearbeiten]MLPs werden auch in der Verkehrsvorhersage und Verkehrssteuerung eingesetzt. Sie können Verkehrsdaten analysieren, Verkehrsmuster erkennen und Vorhersagen über Verkehrsflüsse und -staus treffen. Basierend auf diesen Vorhersagen können Verkehrssteuerungssysteme optimiert werden, um den Verkehrsfluss zu verbessern, Verkehrsengpässe zu minimieren und die Effizienz des Verkehrsnetzes zu erhöhen. MLPs spielen eine wichtige Rolle bei der Entwicklung von intelligenten Verkehrssystemen und der Realisierung von Smart Cities.

Mustererkennung und Datenanalyse

[Bearbeiten | Quelltext bearbeiten]MLPs werden häufig für Mustererkennung und Datenanalyse eingesetzt. Sie können komplexe Datenstrukturen verarbeiten, nichtlineare Beziehungen erkennen und Vorhersagen treffen. Sie finden Anwendung in der Wettervorhersage, der Analyse von Sensordaten, der Erkennung von Mustern in biologischen Daten, der Textanalyse und der Personalisierung von Diensten und Empfehlungen. MLPs sind ein wertvolles Werkzeug zur Extraktion von Informationen aus großen und komplexen Datensätzen.

Spiel-KI und Entscheidungsfindung

[Bearbeiten | Quelltext bearbeiten]MLPs werden auch in der künstlichen Intelligenz von Spielen eingesetzt, um intelligente Gegner zu schaffen und Spielentscheidungen zu treffen. Sie können lernen, das Spielverhalten von menschlichen Spielern zu analysieren, Spielstrategien zu entwickeln und adaptive Entscheidungen zu treffen. MLPs finden Anwendung in Spielen wie Schach, Go, Poker und Videospielen, wo sie dazu beitragen, herausfordernde und realistische Spielerfahrungen zu schaffen.

MLPs haben eine breite Palette von Anwendungen in verschiedenen Bereichen gezeigt. Ihre Fähigkeit, komplexe Muster zu erkennen, aus Daten zu lernen und Vorhersagen zu treffen, macht sie zu einem leistungsstarken Werkzeug in vielen wissenschaftlichen, industriellen und technologischen Anwendungen. Durch kontinuierliche Forschung und Weiterentwicklung können MLPs ihre Leistungsfähigkeit weiter verbessern und neue innovative Anwendungen ermöglichen.

Literatur

[Bearbeiten | Quelltext bearbeiten]- Yann LeCun, Yoshua Bengio, Geoffrey Hinton: Deep learning. In: Nature. Band 521, Nr. 7553. Springer, 2015, ISSN 0028-0836, S. 436–444, doi:10.1038/nature14539 (englisch).

- Ian Goodfellow, Yoshua Bengio, Aaron Courville: Deep learning. In: Genetic Programming and Evolvable Machines. Band 19. MIT Press, 2016, ISSN 1389-2576, S. 305–307, doi:10.1007/s10710-017-9314-z (englisch).

- Christopher M. Bishop: Pattern Recognition and Machine Learning. Springer, New York 2006, ISBN 978-0-387-31073-2 (englisch).

- Jürgen Schmidhuber: Deep Learning in Neural Networks: An Overview. In: Neural networks: The official journal of the International Neural Network Society, European Neural Network Society and Japanese Neural Network Society. Band 61, 2015, ISSN 0893-6080, S. 85–117, doi:10.1016/j.neunet.2014.09.003 (englisch).

- Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton: ImageNet Classification with Deep Convolutional Neural Networks. In: F. Pereira et al. (Hrsg.): Advances in Neural Information Processing Systems (NIPS 2012). Band 25. Curran Associates, 2012, ISBN 978-1-62748-003-1, S. 1097–1105 (englisch, neurips.cc [PDF; 1,4 MB; abgerufen am 15. Juni 2023]).

Weblinks

[Bearbeiten | Quelltext bearbeiten]- Danny Busch: Tutorial - Das Perzeptron. 25. November 2018 (mehrteilig).

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Meirambek Mukhametkhan, Olga Krestinskaya, Alex Pappachen James: Analysis of Multilayer Perceptron with Rectifier Linear Unit Activation Function. In: Institute of Electrical and Electronics Engineers (Hrsg.): Proceedings of the Second International Conference on Computing and Network Communications (CoCoNet'18). Astana 2018, ISBN 978-1-5386-5929-8, S. 245–249, doi:10.1109/CoCoNet.2018.8476902 (englisch).

- ↑ Meenu Sreedharana, Ahmed M. Khedra, Magdi El Bannany: A Multi-Layer Perceptron Approach to Financial Distress Prediction with Genetic Algorithm. In: Automatic Control and Computer Sciences. Band 54, Nr. 6. Allerton Press, 2020, ISSN 0146-4116, S. 475–482, doi:10.3103/S0146411620060085 (englisch).