Probabilistische Klassifikation

Bei der probabilistischen Klassifikation sagt ein maschineller Klassifikator zu einer gegebenen Beobachtung eine Wahrscheinlichkeitsverteilung für eine Menge von Klassen vorher, statt beispielsweise nur die wahrscheinlichste Klasse zurückzugeben. Die vorhergesagte Wahrscheinlichkeit kann entweder direkt verwendet oder in ein Ensemble mit Vorhersagen weiterer Modelle kombiniert werden.

Definition

[Bearbeiten | Quelltext bearbeiten]Ein gewöhnlicher, nicht probabilistischer Klassifikator kann als Funktion betrachtet werden, die einer Beobachtung ein Klassenlabel zuordnet:

- .

Die Beobachtung stammt aus einer Menge aller möglichen Beobachtungen (bspw. Dokumente oder Bilder). Die möglichen Labels bilden eine endliche Menge .

Probabilistische Klassifikatoren beschreiben im Gegensatz dazu eine bedingte Wahrscheinlichkeit . Das heißt, sie weisen für eine Beobachtung jedem möglichen Label eine Wahrscheinlichkeit zu, wobei die Summe der Wahrscheinlichkeiten 1 beträgt. Aus dieser Wahrscheinlichkeitsverteilung kann bei Bedarf eine einzelne Klasse gewählt werden, um einen nicht probabilistischen Klassifikator zu erhalten. Optimalerweise wird die Klasse mit der höchsten Wahrscheinlichkeit gewählt, d. h.:[1]:39–40

Wahrscheinlichkeitskalibrierung

[Bearbeiten | Quelltext bearbeiten]

Manche Klassifikationsmodelle haben von Grund auf eine probabilistische Ausgabe, zum Beispiel Naive Bayes, logistische Regression und neuronale Netze mit Softmax-Ausgabe. Allerdings können die vorhergesagten Wahrscheinlichkeiten durch verschiedene Effekte verzerrt sein.

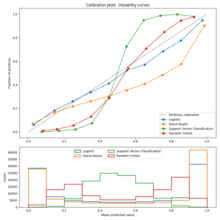

Bei gut kalibrierten Klassifikatoren kann die vorhergesagte Wahrscheinlichkeit einer Klasse direkt interpretiert werden. Von allen Beobachtungen, bei denen der Klassifikator für eine bestimmte Klasse beispielsweise ungefähr eine Wahrscheinlichkeit von 80 Prozent angibt, sollen ungefähr 80 Prozent tatsächlich zu dieser Klasse gehören.[2] Die Kalibrierung kann mithilfe einer Kalibrationskurve untersucht werden. Größere Abweichungen von der Diagonalen deuten auf eine schlechte Kalibrierung hin.

Um die Kalibrierung eines schlecht kalibrierten Modells zu verbessern, können verschiedene Techniken verwendet werden. Im binären Fall sind dies zum Beispiel Platt Scaling, das ein logistisches Regressionsmodell lernt,[3] oder isotonische Regression,[4] die Platt Scaling überlegen ist, wenn ausreichend viele Daten vorhanden sind.[5]

Der Hosmer-Lemeshow-Test wird zur Überprüfung der Kalibrierung eines Modells eingesetzt[6].

Anwendungen

[Bearbeiten | Quelltext bearbeiten]Probabilistische Klassifikation findet zum Beispiel bei diskreten Ereigniszeitmodellen Anwendung. Hier ist insbesondere die Kalibrierung wichtig, damit der Klassifikator die bedingte Ausfallwahrscheinlichkeit richtig schätzt und der Klassifikator somit zur Schätzung der Überlebensfunktion verwendet werden kann.

Siehe auch

[Bearbeiten | Quelltext bearbeiten]Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Christopher M. Bishop: Pattern Recognition and Machine Learning. Springer Science+Business Media, 2006, ISBN 978-0-387-31073-2.

- ↑ Comparison of Calibration of Classifiers. In: scikit-learn. Abgerufen am 28. Juli 2020 (englisch).

- ↑ John C. Platt: Probabilistic Outputs for Support Vector Machines and Comparisons to Regularized Likelihood Methods. In: Advances in large margin classifiers. Band 10, Nr. 3, 1999, S. 61–74.

- ↑ Bianca Zadrozny, Charles Elkan: Transforming classifier scores into accurate multiclass probability estimates. In: Transforming classifier scores into accurate multiclass probability estimates. 2002, S. 694–699.

- ↑ Alexandru Niculescu-Mizil, Rich Caruana: Predicting good probabilities with supervised learning. In: Proceedings of the 22nd international conference on Machine learning. 2005, S. 625–632.

- ↑ Yingxiang Huang, Wentao Li, Fima Macheret, Rodney A Gabriel, Lucila Ohno-Machado: A tutorial on calibration measurements and calibration models for clinical prediction models. In: Journal of the American Medical Informatics Association. Band 27, Nr. 4, 2020, S. 621–633, doi:10.1093/jamia/ocz228.