Überabgetasteter binärer Bildsensor

Ein überabgetasteter binärer Bildsensor ist eine neue Art Bildsensor, deren Eigenschaften an herkömmlichen photographischen Film erinnern.[1][2] Jeder Bildpunkt im Sensor hat eine binäre Ausgabe und gibt eine auf nur ein Bit quantisierte Messung der örtlichen Lichtintensität aus. Die Antwortfunktion des Bildsensor ist nichtlinear und ähnlich einer logarithmischen Funktion, was den Sensor für Hochkontrastbilder geeignet macht.[1]

Einführung

[Bearbeiten | Quelltext bearbeiten]Vor dem Aufkommen digitaler Bildsensoren nutzte die Photographie für den überwiegenden Teil ihrer Geschichte Film für die Aufzeichnung von Lichtbildinformationen. Die Grundlage jeglichen photographischen Films ist eine große Anzahl lichtempfindlicher Körner aus Silberhalogenid-Kristalle.[3] Bei der Belichtung hat jedes mikrometergroße Korn ein binäres Schicksal: Es wird entweder von einigen einfallenden Photonen getroffen und wird „belichtet“ oder wird von dem Photonenbeschuss verfehlt und bleibt „unbelichtet“. Im folgenden Entwicklungsprozess werden belichtete Körner wegen ihrer veränderten chemischen Eigenschaften zu metallischem Silber umgewandelt und tragen zu opaken Stellen des Films bei; unbelichtete Körner werden ausgewaschen und hinterlassen transparente Bereiche auf dem Film. Daher ist photographischer Film im Grunde ein binäres Bildmedium, das örtliche Dichteunterschiede opaker Silberkörner für die Kodierung der ursprünglichen Lichtintensität nutzt. Dank der kleinen Größe und der großen Anzahl dieser Körner erkennt man bei einem gewissen Betrachtungsabstand diese quantisierte Natur des Filmes kaum und sieht nur einen kontinuierlichen Grauton.

Das Konstruieren eines binären Sensors, der das Prinzip des photographischen Films nachahmt, wurde zuerst von Fossum ausgemalt,[4] welcher den Namen digital film sensor prägte. Jeder Bildpunkt im Sensor hat eine binäre Ausgabe und gibt eine auf nur ein Bit quantisierte Messung der örtlichen Lichtintensität aus. Zu Beginn der Belichtungszeit sind alle Bildpunkte auf 0 gesetzt. Ein Bildpunkt wird dann auf 1 gesetzt, wenn die innerhalb der Belichtungszeit generierte Ladung mindestens einen Schwellwert q erreicht. Das Auslesen der Bildpunkte kann wie bei einem DRAM geschehen.[5] Mit der mit DRAM-Technologie erzielbaren räumlichen Auflösung von unter 20 nm ist die nur binäre Ladungsauflösung kein wesentlicher Nachteil, denn die kleinen Pixel haben ohnehin eine niedrige Sättigungskapazität (höchste Zahl Photoelektronen, die ein Bildpunkt enthalten kann). Zudem bedeuten Bildpunktgrößen weit unter der Beugungsgrenze von Licht eine hohe räumliche Überabtastung des Lichtfeldes, was den Nachteil der Quantisierung auf nur ein Bit mindert. Eine hohe zeitliche Überabtastung verbessert den Dynamikumfang weiter.

Bildgewinnung

[Bearbeiten | Quelltext bearbeiten]Die Linse

[Bearbeiten | Quelltext bearbeiten]

Man denke an ein vereinfachtes Kameramodell wie es in Abbildung 1 gezeigt ist. Das ist das einfallende Lichtintensitätsfeld. Durch die Annahme gleichbleibender Lichtintensitäten innerhalb einer kurzen Belichtungsdauer kann das Feld allein durch eine Funktion der räumlichen Variable modelliert werden. Nach dem Durchlaufen des optischen Systems wird das ursprüngliche Lichtfeld durch die Linse gefiltert, welche sich wie ein lineares System mit einer festen Impulsantwort verhält. Durch Unvollkommenheiten (beispielsweise Abbildungsfehler) in der Linse kann die Impulsantwort, auch bekannt als die Punktspreizfunktion (PSF) des optischen Systemes, nicht gleich Dirac Delta sein und begrenzt somit die Auflösung des beobachtbaren Lichtfeldes. Eine grundlegendere, physikalische Begrenzung beruht allerdings auf der Lichtbeugung.[6] Dadurch ist die PSF auch mit einer idealen Linse unvermeidbar ein kleiner, verwaschener Fleck. In der Optik wird ein solcher beugungsbegrenzter Fleck oft als Beugungsscheibchen bezeichnet,[6] deren Radius berechnet werden kann als

wobei die Wellenlänge des Lichtes und die Blendenzahl des optischen Systems ist. Durch die Tiefpass-Natur (weichzeichnend) der PSF hat die resultierende eine begrenzte räumliche Auflösung, hat also eine begrenzte Anzahl von Freiheitsgraden pro Raumeinheit.

Der Sensor

[Bearbeiten | Quelltext bearbeiten]

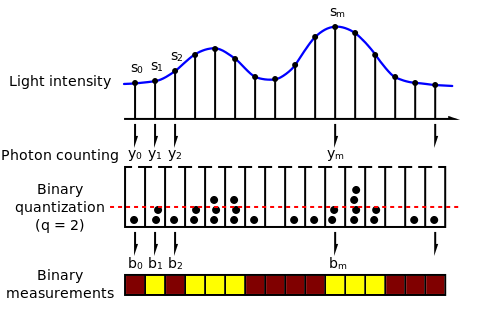

Abbildung 2 zeigt das binäre Sensormodell. Die stehen für die Belichtung, die ein Sensorpixel empfangen hat. Abhängig von den örtlichen Werten von (in der Abbildung als „buckets“ dargestellt) sammelt jedes Pixel eine unterschiedliche Anzahl Photonen, die auf seiner Oberfläche eintreffen. ist die Anzahl der Photonen, die während der Belichtungszeit auf der Oberfläche des ten Pixel einfallen. Die Beziehung zwischen und der Photonenanzahl ist stochastisch. Genauer: kann als Realisierungen einer Poissonschen Zufallsvariable, deren Intensitätsparameter gleich ist.

Jedes Pixel im Bildsensor fungiert als ein lichtempfindliches Gerät, das Photonen in elektrische Signale überträgt, deren Amplitude proportional zur Anzahl darauf eintreffender Photonen ist. Bei einem herkömmlichen Sensorentwurf werden die analogen elektrischen Signale nachher durch einen Analog-Digital-Umsetzer zu 8 bis 14 Bits (gewöhnlich je mehr desto besser) quantisiert. Der binäre Sensor quantisiert hingegen auf 1 Bit. In Abbildung 2 ist die quantisierte Ausgabe des ten Pixels. Da die Photonenanzahlen aus Zufallsvariablen bezogen werden, sind es die Ausgaben des Binärsensors ebenfalls.

Räumliche und zeitliche Überabtastung

[Bearbeiten | Quelltext bearbeiten]Wenn zeitliche Überabtastung zugelassen wird, also mit gleichbleibender Belichtungszeit nacheinander mehrere separate Bilder aufgenommen werden, so gleicht die Leistung des binären Sensors unter gewissen Bedingungen der eines Sensors mit demselben Maß an räumlicher Überabtastung.[2] Dies bedeutet, dass zwischen räumlicher und zeitlicher Überabtastung abgewogen werden kann. Dies ist recht wichtig, da üblicherweise technische Begrenzungen für die Pixelgröße und die Belichtungszeit bestehen.

Vorteile gegenüber herkömmlichen Sensoren

[Bearbeiten | Quelltext bearbeiten]Durch die begrenzte Sättigungskapazität herkömmlicher Bildpunkte wird das Pixel bei zu großer Lichtintensität gesättigt. Aus diesem Grund ist der Dynamikumfang des Pixels gering. Beim überabgetasteten binären Bildsensor ist der Dynamikumfang nicht für ein einzelnes, sondern eine Pixelgruppe definiert, was zu einem hohen Dynamikumfang führt.[2]

Rekonstruktion

[Bearbeiten | Quelltext bearbeiten]

Eines der wichtigsten Probleme bei überabgetasteten binären Bildsensoren ist die Rekonstruktion der Lichtintensität aus der binären Messung . Es kann mit der Maximum-Likelihood-Methode gelöst werden.[2] Abbildung 4 zeigt die Ergebnisse einer Rekonstruktion der Lichtintensität aus 4096 binären Aufnahmen aus einer Einzelphotonen-Lawinenphotodioden-Kamera (SPADs-Kamera).[7]

Quellen

[Bearbeiten | Quelltext bearbeiten]- ↑ a b L. Sbaiz, F. Yang, E. Charbon, S. Süsstrunk und M. Vetterli: The Gigavision Camera, Proceedings of IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Seiten 1093–1096, 2009.

- ↑ a b c d F. Yang, Y. M. Lu, L. Saibz und M. Vetterli: Bits from Photons: Oversampled Image Acquisition Using Binary Poisson Statistics, IEEE Transaction on Image Processing, Band 21, Ausgabe 4, Seiten 1421–1436, 2012.

- ↑ T. H. James: The Theory of The Photographic Process, 4. Ausgabe, New York: Macmillan Publishing Co., Inc., 1977.

- ↑ E. R. Fossum: What to do with sub-diffraction-limit (SDL) pixels? – A proposal for a gigapixel digital film sensor (DFS), in IEEE Workshop on Charge-Coupled Devices and Advanced Image Sensors, Nagano, Juni 2005, Seiten 214–217.

- ↑ S. A. Ciarcia: A 64K-bit dynamic RAM chip is the visual sensor in this digital image camera, Byte Magazine, Seiten 21–31, September 1983.

- ↑ a b M. Born und E. Wolf, Principles of Optics, 7. Ausgabe, Cambridge: Cambridge University Press, 1999

- ↑ a b L. Carrara, C. Niclass, N. Scheidegger, H. Shea und E. Charbon: A gamma, X-ray and high energy proton radiation-tolerant CMOS image sensor for space applications, in IEEE International Solid-State Circuits Conference, Februar 2009, Seiten 40–41.