Bayes-Schätzer

Ein Bayes-Schätzer (IPA: [], ; benannt nach Thomas Bayes) ist in der mathematischen Statistik eine Schätzfunktion, die zusätzlich zu den beobachteten Daten eventuell vorhandenes Vorwissen über einen zu schätzenden Parameter berücksichtigt. Gemäß der Vorgehensweise der bayesschen Statistik wird dieses Vorwissen durch eine Verteilung für den Parameter modelliert, die A-priori-Verteilung. Mit dem Satz von Bayes ergibt sich die bedingte Verteilung des Parameters unter den Beobachtungsdaten, die A-posteriori-Verteilung. Um daraus einen eindeutigen Schätzwert zu erhalten, werden Lagemaße der A-posteriori-Verteilung, wie Erwartungswert, Modus oder Median, als sogenannte Bayes-Schätzer verwendet. Da der A-posteriori-Erwartungswert der wichtigste und in der Praxis am häufigsten angewendete Schätzer ist, bezeichnen auch einige Autoren diesen als den Bayes-Schätzer.[1] Allgemein definiert man einen Bayes-Schätzer als denjenigen Wert, der den Erwartungswert einer Verlustfunktion unter der A-posteriori-Verteilung minimiert. Für eine quadratische Verlustfunktion ergibt sich dann gerade der A-posteriori-Erwartungswert als Schätzer.

Definition

[Bearbeiten | Quelltext bearbeiten]Es bezeichnen den zu schätzenden Parameter und die Likelihood, also die Verteilung der Beobachtung in Abhängigkeit von . Die A-priori-Verteilung des Parameters sei mit bezeichnet. Dann ist

die A-posteriori-Verteilung von . Es sei weiter eine Funktion , genannt Verlustfunktion, gegeben, deren Werte den Verlust modellieren, den man bei einer Schätzung von durch erleidet. Dann heißt ein Wert , der den Erwartungswert

des Verlustes unter der A-posteriori-Verteilung minimiert, ein Bayes-Schätzer von .[2] Im Fall einer diskreten Verteilung von sind die Integrale über als Summation über zu verstehen.

Spezialfälle

[Bearbeiten | Quelltext bearbeiten]A-posteriori-Erwartungswert

[Bearbeiten | Quelltext bearbeiten]Eine wichtige und häufig verwendete Verlustfunktion ist die quadratische Abweichung

- .

Mit dieser Verlustfunktion ergibt sich als Bayes-Schätzer der Erwartungswert der A-posteriori-Verteilung, kurz der A-posteriori-Erwartungswert

- .

Das sieht man auf folgende Weise: Differenziert man nach , ergibt sich

- .

Nullsetzen dieser Ableitung und Auflösen nach liefert obige Formel.

A-posteriori-Median

[Bearbeiten | Quelltext bearbeiten]Ein weiterer wichtiger Bayes-Schätzer ist der Median der A-posteriori-Verteilung. Er ergibt sich bei Verwendung der stückweise linearen Verlustfunktion

- ,

des Betrags des absoluten Fehlers. Bei einer stetigen A-posteriori-Verteilung ergibt sich der zugehörige Bayes-Schätzer als Lösung der Gleichung

- ,

also als Median der Verteilung mit Dichte .

A-posteriori-Modus

[Bearbeiten | Quelltext bearbeiten]Für diskret verteilte Parameter bietet sich die Null-Eins-Verlustfunktion

an, die allen falschen Schätzungen einen konstanten Verlust zuordnet und nur eine exakte Schätzung nicht „bestraft“. Als Erwartungswert dieser Verlustfunktion ergibt sich die A-posteriori-Wahrscheinlichkeit des Ereignisses , also . Diese wird minimal an den Stellen, an denen maximal ist, das heißt an den Modalwerten der A-posteriori-Verteilung.

Bei stetig verteilten hat das Ereignis für alle Wahrscheinlichkeit null. In diesem Fall kann man stattdessen für ein (kleines) vorgegebenes die Verlustfunktion

betrachten. Im Limes ergibt sich dann ebenfalls der A-posteriori-Modus als Bayes-Schätzer.

Im Falle einer Gleichverteilung als A-priori-Verteilung ergibt sich der Maximum-Likelihood-Schätzer, der somit einen Spezialfall eines Bayes-Schätzers darstellt.

Beispiel

[Bearbeiten | Quelltext bearbeiten]

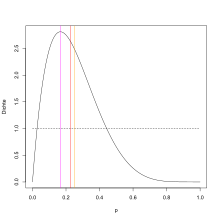

Eine Urne enthält rote und schwarze Kugeln in unbekannter Zusammensetzung, das heißt, die Wahrscheinlichkeit , eine rote Kugel zu ziehen, ist unbekannt. Um zu schätzen, werden Kugeln nacheinander mit Zurücklegen gezogen: Nur eine einzige Ziehung liefert eine rote Kugel, es wird also beobachtet. Die Anzahl der gezogenen roten Kugeln ist binomialverteilt mit und , also gilt

- .

Da über den zu schätzenden Parameter keinerlei Information vorliegt, wird die Gleichverteilung als A-priori-Verteilung verwendet, das heißt für . Als A-posteriori-Verteilung ergibt sich somit

- .

Das ist die Dichte einer Beta-Verteilung mit den Parametern und . Damit ergibt sich als A-posteriori-Erwartungswert und als A-posteriori-Modus . Der A-posteriori-Median muss numerisch bestimmt werden und ergibt ungefähr . Allgemein ergibt sich bei roten Kugeln in Ziehungen als A-posteriori-Erwartungswert und , also der klassische Maximum-Likelihood-Schätzer, als A-posteriori-Modus. Für nicht zu kleine Werte von ist eine gute Näherung für den A-posteriori-Median.

Praktische Berechnung

[Bearbeiten | Quelltext bearbeiten]Ein Hindernis bei der Anwendung von Bayes-Schätzern kann ihre numerische Berechnung sein. Ein klassischer Ansatz ist die Verwendung von sogenannten konjugierten A-priori-Verteilungen, bei denen sich eine A-posteriori-Verteilung aus einer bekannten Verteilungsklasse ergibt, deren Lageparameter dann einfach in einer Tabelle nachgeschlagen werden können. Verwendet man beispielsweise im obigen Urnenexperiment eine beliebige Betaverteilung als Prior, dann ergibt sich auch eine Betaverteilung als A-posteriori-Verteilung.[3]

Für allgemeine A-priori-Verteilungen zeigt die obige Formel des A-posteriori-Erwartungswerts, dass zu seiner Berechnung zwei Integrale über den Parameterraum bestimmt werden müssen. Eine klassische Näherungsmethode ist die Laplace-Approximation, bei der die Integranden als Exponentialfunktion geschrieben werden und anschließend die Exponenten durch eine quadratische Taylor-Approximation angenähert werden.[4]

Mit dem Aufkommen leistungsfähiger Computer wurden weitere numerische Verfahren zur Berechnung der auftretenden Integrale anwendbar (siehe Numerische Integration). Ein Problem stellen vor allem hochdimensionale Parametermengen dar, also der Fall, dass sehr viele Parameter aus den Daten geschätzt werden sollen. Hierbei kommen häufig Monte-Carlo-Verfahren als Näherungsverfahren zum Einsatz.[5]

Literatur

[Bearbeiten | Quelltext bearbeiten]- Leonhard Held: Methoden der statistischen Inferenz. Likelihood und Bayes. Springer Spektrum, Heidelberg 2008, ISBN 978-3-8274-1939-2.

- Erich Leo Lehmann, George Casella: Theory of Point Estimation. 2. Auflage. Springer, New York u. a. 1998, ISBN 0-387-98502-6, Kapitel 4.

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Karl-Rudolf Koch: Einführung in die Bayes-Statistik. Springer, Berlin/Heidelberg 2000, ISBN 3-540-66670-2, S. 66 (eingeschränkte Vorschau in der Google-Buchsuche).

- ↑ Leonhard Held: Methoden der statistischen Inferenz. Likelihood und Bayes. Springer Spektrum, Heidelberg 2008, ISBN 978-3-8274-1939-2.

- ↑ Held: Methoden der statistischen Inferenz. 2008, S. 146–148.

- ↑ Held: Methoden der statistischen Inferenz. 2008, S. 188–191.

- ↑ Held: Methoden der statistischen Inferenz. 2008, S. 192–208.