Diskussion:Grafikprozessor/Archiv

Grafikchip-Rangliste

Hm, getreu dem Satz "Es ist enorm schwer eine Rangliste zu erstellen, vor allem wenn es um Grafikkarten geht" frage ich mich, ist es überhaupt sinnvoll? Und vor allem, nach welchen Kriterien wird die Performance beurteilt? Meiner Meinung nach, macht so eine Liste ohne genau Definition, auf welchen Werte das basiert keinen Sinn! Z.B. ist eine Radeon X1800 nicht immer schneller als eine GeForce 7800 GTX... --Stickedy 10:10, 16. Nov 2005 (CET)

- halte ich hier für unangebracht.--Moritzgedig 22:16, 23. Aug. 2007 (CEST)

Ist es eigentlich möglich Dual Core GPUs zu produzieren? Oder gibt es so etwas schon? --Murphy-Sepp 19:41, 20. Jul 2006 (CEST)

- das geht natürlich und wird wohl auch in zukunft kommen. arbeitsteilung wurde schon zu zeiten von 3dfx vorgenommmen. in gewissem maße gibt es dies heute schon, denn die frei programmierbaren shader entsprechen ja prinzipiell kleinen eigenständigen rechenwerken. gruss --Murkel (anmurkeln) 16:28, 14. Apr. 2007 (CEST)

- die frage macht eigentlich keinen sinn, eine GPU arbeitet nicht einen thread ab sondern immer viele.--Moritzgedig 22:16, 23. Aug. 2007 (CEST)

Moorschesgesetz

"Der Leistungszuwachs bei Grafikprozessoren hat mit einem jährlichen Faktor von 2,4 sogar das Mooresche Gesetz übertroffen"[br] Leistungszuwachs und Moorschesgesetz haben direkt nichts miteinander zu tun.--Moritzgedig 21:01, 29. Okt. 2006 (CET)

- da aber komplexität und leistungszuwachs in direktem verhältnis stehen, stimmt die aussage dann wieder. gruss --Murkel (anmurkeln) 16:28, 14. Apr. 2007 (CEST)

ich finde es ganz ehrlich ein wenig bitter... :( kann man da bei den gpu bildern nicht auch eines von einem ATI radeon prozessor anknüpfen! das halte ich für sehr wichtig!

Folding@home und GPUs

Im Artikel steht, dass nur ATI-GPUs unterstützt werden. Ich dächte aber irgendwo mal gelesen zu haben, dass auch die nvidia G80-GPUs unterstützt werden. - Appaloosa 14:41, 15. Jun. 2007 (CEST)

- nein bisher gibts nur unterstützung für x1800 und x1900 quelle. gründe stehen ebenfalls dort. gruß --Murkel (anmurkeln) 19:46, 15. Jun. 2007 (CEST)

- es werden alle Radeon X1xx0xx modelle unterstützt, sonst leider keine.--Moritzgedig 10:26, 11. Aug. 2007 (CEST)

MiByte vs. MByte

Zum tausendsten Male: Die Hersteller geben MByte statt MiByte an. Also bitte ich das dämliche "Ich-habe-Recht-mit-der-Angabe-der-Binärprefixe" bei der Wiki zu utnerlassen. 11:25, 30. Jun. 2008 (CEST) Soreia

- dein *aufdentischhauen* schafft aber noch lange kein konsens. zum einen richtet sich wikipedia nicht nach herstellerangaben. das wär ja noch schöner, bei dem unfug, der da manchmal steht. zum anderen gabs aktuell ein Wikipedia:Meinungsbilder/Benennung von Datenmengen zum verwenden der binärpräfixe. solche entscheidungen sind aber nicht bindend. gruss --Murkel (anmurkeln) 20:06, 1. Jul. 2008 (CEST)

Marktanteile Grafik

Hi, ich habe ein neues Diagramm erstellt mit den Marktanteilen aus den Jahren 2012-2013. Vielleicht kann man das ja hier einpflegen und das alte Diagramm ersetzen! --Isenherz (Diskussion) 16:05, 21. Okt. 2013 (CEST)

- Sagt mir welche ihr haben wollt.--Isenherz (Diskussion) 11:51, 22. Okt. 2013 (CEST)

- Nachdem jetzt hier keine Antwort kam habe ich die Grafik ausgetauscht. --Isenherz (Diskussion) 13:55, 29. Okt. 2013 (CET)

Bilder

Ich glaube man sollte mal aktuellere Bilder verwenden z.b von der neuen geforce 8800 (nicht signierter Beitrag von 84.158.85.21 (Diskussion) 19:54, 12. Dez. 2006 (CET))

- wozu? am sachverhalt und der aussagekraft eines artikels ändert sich fast nichts, nur wenn aktuelle bilder verwendet werden. gruss --Murkel (anmurkeln) 16:28, 14. Apr. 2007 (CEST)

was heißt....

...konnten diese Prozessoren auch Sprites darstellen... ... verfügten bereits über Blitting Funktionen... ... als ein Prozessor mit integrierten Transform-, Lighting-, Triangle-Setup/Clipping- ...

Ich denke wenn ich wüsste wovon da geredet wird, würde ich den Artikel nicht mehr lesen....

- da hat jetzt wer die begriffe verlinkt.--Moritzgedig 22:27, 23. Aug. 2007 (CEST)

Was auch noch interessant wäre, wären die Unterschiede der internen Architekturen zu normalen CPUs. Ich habe mal gehört, dass Grafikkarten manchmal über einen getrenten Daten- und Befehlsbus verfügen... stimmt das?

- du meinst vielleicht die Harward-architektur? die ersten grafikprozessoren waren garnicht zu vergleichen, da sie nicht wirklich programierbar waren. heute bewegen sich GPU und CPU aufeinander zu sodas sie schon recht ähnlich sind.--Moritzgedig 22:27, 23. Aug. 2007 (CEST)

Dennoch Danke für den Artikel, ist ein schöner Anfang.

mfg fsk (nicht signierter Beitrag von 82.210.249.9 (Diskussion) 15:32, 2. Okt. 2006 (CEST))

Mehrere grafikprozessoren

"Durch NVidias Scalable Link Interface (Kurz: SLI) oder ATI's Pendant Crossfire ist es nun möglich [...] mit mehreren Grafikprozessoren zu arbeiten."[br] das ließt sich, als wäre das was neues, ist es aber nicht. siehe 3Dfx. (nicht signierter Beitrag von Moritzgedig (Diskussion | Beiträge) 20:58, 29. Okt. 2006 (CET))

- wird entsprechend geändert, gruß --Murkel (anmurkeln) 16:28, 14. Apr. 2007 (CEST)

erste 3D beschleunigung

"eigenständig Dreieckstransformationen" konnten die das damals schon? ich dachte das hätte es erst mit DX8.1 T&L gegeben.

damals waren Grakas doch auf das beschränkt was man heute ROP nennt.

"aktuelle 3D modelle laden, texturen auflegen, rendern" < das war es was die konnten. (nicht signierter Beitrag von Moritzgedig (Diskussion | Beiträge) 06:29, 14. Jun. 2007 (CEST))

- du hast recht. ich habe den artikel dahingehend geändert. nebenbei, bitte unterschreibe deine beiträge auf diskussionsseiten. gruß --Murkel (anmurkeln) 17:26, 14. Jun. 2007 (CEST)

Verarbeitung der Daten durch den Grafikprozessor

Hallo. Ich wäre dafür etwas mehr Technik in den Artikel einfließen zu lassen. Etwas zur Technik steht ja schon in der Geschichte, was aber etwas wenig ist. Kann vielleicht jemand den Aufbau eines Grafikchips erklären und gleichzeitig sagen wie die Daten durch welche Mechanismen im Grafikprozessor verarbeitet werden? Wobei man hier wohl auch zwischen den Grafikprozessoren, die auf den Rendering-Pipeline basieren und denen die auf der Unified-Shader-Architektur basieren unterscheiden sollte. Bisher gibt es nur Artikel zu Shader und Rendering-Pipelines, aber wie der ganze Grafikprozessor funktioniert, ist nirgends erklärt und ich denke, das wäre hier der passende Ort. Dann könnte man hier auch gleichzeitig so Begriffe wie ROPs, TMUs, TAUs und deren Aufgabe erwähnen. Auch das Zusammenspiel der Komponenten könnte man hier etwas erläutern. Was meint ihr? Eine mögliche Überschrift für diesen Abschnitt habe ich hiermit in der Überschrift schon mal vorgeschlagen Juri S. 17:51, 11. Okt. 2007 (CEST)

Rohleistung mit Transistoranzahl verknüpfen?

Ich weiß jetzt nicht, wer auf die Idee kam, die Transistoranzahl zu vergleichen um die Rohleistung der GPU gegenüber der CPU zu verdeutlichen, aber der Vergleich hinkt immer noch und zwar gewaltig. Eine moderne CPU taktet mit über 3 GHz. Eine moderne GPU von AMD mit unter 1 GHz. Demnach müsste die GPU erst einmal 3-mal soviel Transistoren haben um den 3-mal so niedrigen Takt auszugleichen. Taktbereinigt kann man hier anhand der Transistoren also nicht von höherer Rohleistung sprechen. Die hohe Transistoranzahl und der niedrige Takt unterstreicht höchstens die hohe Parallelisierung bei der GPU gegenüber der schlanken und hoch getakteten CPU. --Juri S. 23:48, 16. Feb. 2011 (CET)

Ehem. Grafikchiphersteller

Meines Erachtens fehlt als ehemaliger Hersteller noch wenigstens Hercules. mfg Tec (nicht signierter Beitrag von 87.185.68.233 (Diskussion | Beiträge) 07:55, 7. Mai 2010 (CEST))

- Weis jemand, ob Hercules jemals selbst GPUs für 2D/3D-Beschleuniger gebaut hat? Oder nur einfache Grafikkarten?

- --arilou (Diskussion) 13:20, 20. Jun. 2017 (CEST)

Ergänzungsvorschlag: eGPU ( Externer Graphics processing unit )

Es gibt auch für schwache Laptop PC eine externe Dokking Station für PCI Grafikkarten.

- Ergänzt. --arilou (Diskussion) 13:17, 20. Jun. 2017 (CEST)

- Archivierung dieses Abschnittes wurde gewünscht von: arilou (Diskussion) 13:17, 20. Jun. 2017 (CEST)

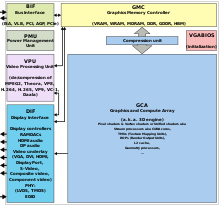

GCA == "Graphic aperture array" ?

Die Abkürzung GCA wird nirgends erläutert, "Graphic aperture array" kann es ja wohl nicht sein (das wäre GAA!). Zudem gibt es "Graphic aperture array" nicht: Alle Google Ergebnisse sind Kopien dieses Artikels, der Begriff ist nicht geläufig. Wenn doch, bitte eine Quelle angeben! (nicht signierter Beitrag von 84.63.80.189 (Diskussion) 21:36, 14. Mär. 2018 (CET))

- Sehe ich ebenso: TF "Begriffsetablierung".

- Hab' den Begriff jetzt erst mal rausgelöscht.

- --arilou (Diskussion) 10:41, 3. Apr. 2018 (CEST)

- Das sehe ich ähnlich. Zudem hatte ich auf der BKL unter ‚GCA‘ auch (noch) nichts Sinnvolles dazu finden können und war schon dabei, den betreffenden Abschnitt (schon leicht überarbeitet, zudem anfänglich mit deutlichem Belege-fehlen-Hinweis) hierher zu schieben. Ebenso verhält es sich mit dem dortigen Bezeichner ‚3D-Engine‘ (oder auch [denglischer] ‚3D Engine‘), da mir dieser (bisher) nicht im hier behandelten Prozessor- oder deutlicher im auch sogenannten Hardware-Umfeld, sondern nur im Weich- oder Software-Bereich bekannt war (siehe dazu ggf. auch unter

3D-Engineoder treffender [ähnlich wie noch immer in der englischsprachigen Wikipedia, gegenwärtig von en:3D engine nach en:Game engine weiterleitend] unter Game Engine oder auch – schon etwas besser übersetzt – unter Spiel-Engine). Nachdem ich eine erste kleine Überarbeitung des betreffenden Abschnittes[1] aber schon begonnen und nahezu abgeschlossen hatte (und im Laufe dessen auch auf diesen Abschnitt hier gestoßen bin), hatte ich mir die nebenan auch genannten (und hier nun leicht nachbeaarbeiteten) Hinweise<!-- Überarbeitung + Verfeinerung dringend notwendig. vgl. en:Graphics Core Next und en:User:ScotXW/amdgpu#Explanations -->mal genauer angeschaut und zudem das wohl wichtigste Bild auch hier (oben rechts) angefügt. Liebe Grüße. -- Abmühung, am 27.9.2018, 09:13 (MESZ) (nachträglich hier gegenwärtig eher nicht Zutreffendes durchgestrichen und u.a. durch einen treffenderen Verweis ersetzt -- Abmühung, am 27.9.2018, 10:45 [MESZ])

- Das sehe ich ähnlich. Zudem hatte ich auf der BKL unter ‚GCA‘ auch (noch) nichts Sinnvolles dazu finden können und war schon dabei, den betreffenden Abschnitt (schon leicht überarbeitet, zudem anfänglich mit deutlichem Belege-fehlen-Hinweis) hierher zu schieben. Ebenso verhält es sich mit dem dortigen Bezeichner ‚3D-Engine‘ (oder auch [denglischer] ‚3D Engine‘), da mir dieser (bisher) nicht im hier behandelten Prozessor- oder deutlicher im auch sogenannten Hardware-Umfeld, sondern nur im Weich- oder Software-Bereich bekannt war (siehe dazu ggf. auch unter

- Habe dazu nun doch noch(mal) wohl besser den schon genannten Belege-fehlen-Hinweis (im betreffenden Abschnitt, nebenan) gesetzt,[2] da ich dafür (außerhalb der Wikipedia) keine (weiter) belastbaren Nachweise finden konnte. -- Abmühung, am 27.9.2018, 09:28 (MESZ)

ROP

Raster Operation Processor leitet hierher weiter, wird aber praktisch gar nicht behandelt. --arilou (Diskussion) 13:12, 2. Jun. 2015 (CEST)

- Habe auch nach Raster Operation Pipeline (ROP) gesucht. Der Artikel bildet die Pipelinestufen der klassischen festverdrahteten 3d Grafikprozessoren überhaupt nicht ab. ROP gehört eigentlich in einen eigenen Artikel und nicht hier her. Noch schlimmer wird es, dass das jetzt mit modernen GPUs ohnehin noch vermischt wird, die keine klassischen feste Pipelinestufen mehr haben. Der Artikel gehört komplett überarbeitet und die jeweiligen Pipelinestufen in einem eigenen Artikel behandelt. --93.229.175.196 03:59, 19. Dez. 2023 (CET)

- Ich habe mal einen Löschantrag für die Weiterleitung erstellt. Wenn die Weiterleitung weg ist, dann kann man den Artikelwunsch für ROP im Fachbereich Informatik eintragen und ein neuer Artikel dazu erstellt werden. --93.229.175.196 04:11, 19. Dez. 2023 (CET)