Robuste Schätzverfahren

Robustes Schätzverfahren ist ein Begriff der schließenden Statistik. Ein Schätzverfahren oder Testverfahren heißt robust, wenn es nicht sensibel auf Ausreißer (Werte außerhalb eines aufgrund einer Verteilung erwarteten Wertebereiches) reagiert.

Die klassischen Schätzmethoden, die in der ersten Hälfte des 20. Jahrhunderts entwickelt wurden, tendieren häufig dazu, bei Vorliegen von Ausreißern in der Stichprobe irreführende Ergebnisse zu liefern. Ein robustes Schätzverfahren orientiert sich deshalb an der Masse der Daten und integriert eine Ausreißeranalyse, um den Einfluss von Modellabweichungen zu reduzieren und ihn bei zunehmender Devianz gegen Null streben zu lassen.

Die Entwicklung robuster Schätzer zur Effizienzsteigerung von Schätzverfahren ist seit den 1980er Jahren ein wichtiges Forschungsanliegen in der mathematischen Statistik. Zu den robusten Verfahren gehören zum Beispiel der RANSAC-Algorithmus und Verfahren, die eine hohe Bruchpunktresistenz aufweisen.

Verfahren zum Messen der Robustheit

[Bearbeiten | Quelltext bearbeiten]- Bruchpunkt

- (Empirische) Einflussfunktion

Beispiel

[Bearbeiten | Quelltext bearbeiten]Ein einfaches robustes Schätzverfahren stellt der (empirische) Median dar, den man anstelle des arithmetischen Mittels verwenden kann, um den Erwartungswert einer symmetrischen Verteilung zu schätzen. Den empirischen Median erhält man, indem man die Beobachtungen der Größe nach sortiert und dann den der Reihenfolge nach mittleren Beobachtungswert als Schätzwert wählt. Ein Beispiel: Es wird eine gewisse Zahl von Messungen durchgeführt, um eine physikalische Größe (etwa die Gravitationskonstante) experimentell zu bestimmen. Man nimmt an, dass die auftretenden Messfehler unsystematisch sind und in beide Richtungen gehen können, die Messwerte also mal zu groß, mal zu klein sind – präziser bzw. formal ausgedrückt, handelt es sich um unabhängige und identisch verteilte Beobachtungen mit symmetrischer Verteilung und dem wahren Wert der zu bestimmenden Größe als Erwartungswert. Es gibt nun gelegentlich einzelne Messwerte, die deutlich von den übrigen abweichen („Ausreißer“, die oben beschriebenen Modellabweichungen); sie sind in der Regel auf Fehler bei der Durchführung des Experiments zurückzuführen („Verwackeln“ der Apparatur, „Verschreiben“ o. ä.). Obwohl extreme Abweichungen eher auf einen Fehler hindeuten und daher solche Beobachtungen eher weniger Einfluss auf das Ergebnis haben sollten, beeinflussen sie das arithmetische Mittel stark; der Einfluss wird sogar umso größer, je deutlicher die Abweichung ist. Der Median hingegen ist gegen solche Ausreißer unempfindlich, also „robust“. Sofern keine Ausreißer vorliegen, liefert er allerdings bei gleicher Zahl von Messwerten im Allgemeinen eine ungenauere Schätzung, da „im Kleinen“ der Schätzwert nur durch eine einzige – nämlich die mittlere – Beobachtung bestimmt wird.

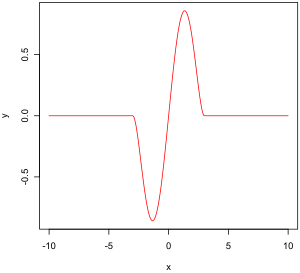

Bei normalverteilten Zufallsvariablen sind Ausreißer eher unwahrscheinlich und der arithmetische Mittelwert liefert eine gute Schätzung für den Erwartungswert. Dagegen ist bei einer t-Verteilung mit einer geringen Anzahl von Freiheitsgraden aufgrund der schweren Verteilungsschwänze die Wahrscheinlichkeit für Ausreißer deutlich erhöht. In der nebenstehenden Abbildung sind beide Schätzer erwartungstreu, aber der Median weist eine geringere Varianz auf als der arithmetische Mittelwert, was für die Robustheit des Medians gegenüber Ausreißern spricht. Mit steigender Anzahl von Freiheitsgraden konvergiert die t-Verteilung gegen die Normalverteilung und Ausreißer werden unwahrscheinlicher. In diesem Fall ist die Varianz des arithmetischen Mittelwerts geringer, weil mehr Information aus den Daten verwendet wird.

Siehe auch

[Bearbeiten | Quelltext bearbeiten]Literatur

[Bearbeiten | Quelltext bearbeiten]- Herbert Büning: Robuste und Adaptive Tests. Walter de Gruyter, Berlin 1991, ISBN 3-11-012827-6.

- Helga Bunke, Olaf Bunke: Nonlinear regression, functional relations and robust methods. Band 2: Non-Linear Functional Relations and Robust Methods. Wiley, New York u. a. 1989, ISBN 0-471-91239-5.

- Frank Hampel, Elvezio M. Ronchetti, Peter J. Rousseeuw, Werner A. Stahel: Robust statistics. The approach based on influence functions. Wiley, New York 2011, ISBN 978-1-118-15068-9.

- David C. Hoaglin, Frederick Mosteller, John W. Tukey: Understanding Robust and Exploratory Data Design. Wiley, New York 2000, ISBN 0-471-38491-7.

- Peter J. Huber: Robust Estimation of a Location Parameter. In: The Annals of Mathematical Statistics. Band 35, Nr. 1, 1964, S. 73–101 (projecteuclid.org).

- Peter J. Huber, Elvezio M. Ronchetti: Robust Statistics. 2. Auflage. Wiley, Hoboken 1986, ISBN 978-0-470-12990-6.

- Mia Hubert (Hrsg.): Theory and Application of Recent Robust Methods. Birkhäuser, Basel u. a. 2004, ISBN 3-7643-7060-2.

- Werner Stahel (Hrsg.): Directions in Robust Statistics and Diagnostics. 2 Bände. (Bände 33 und 34 von The IMA Volumes in Mathematics and its Applications.) Springer, Berlin u. a. 1991, ISBN 3-540-97530-6, ISBN 3-540-97531-4.

- P. H. Müller (Hrsg.): Lexikon der Stochastik – Wahrscheinlichkeitsrechnung und mathematische Statistik. 5. Auflage. Akademie-Verlag, Berlin 1991, ISBN 978-3-05-500608-1, Robustheit statistischer Verfahren, S. 338–343.

- Ricardo A. Maronna, R. Douglas Martin, Victor J. Yohai, Matías Salibián-Barrera: Robust Statistics – Theory and Methods (With R) (= Wiley Series in Probability and Statics). 2. Auflage. Wiley, Hoboken 2019, ISBN 978-1-119-21468-7.